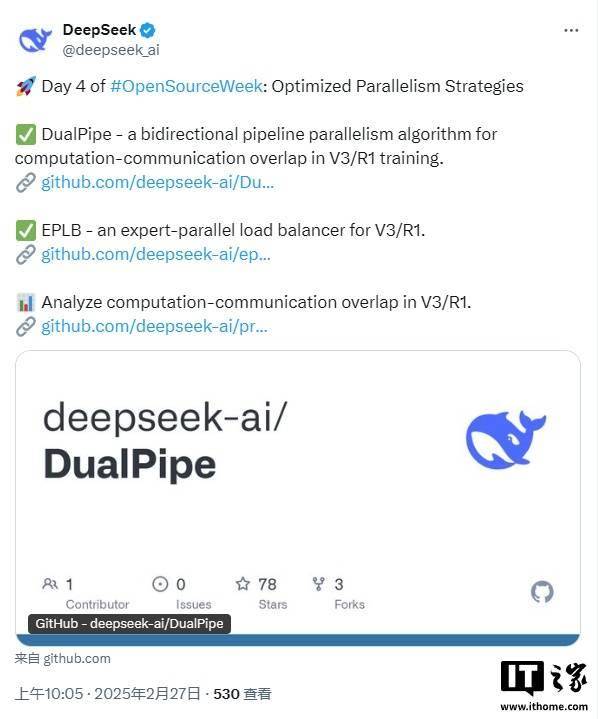

DeepSeek“開源周”活動近日進入尾聲,此次活動的焦點之一是公布了一系列優化并行策略的項目。這些項目旨在提升深度學習訓練的效率,特別是在V3和R1訓練框架中的應用。

其中,“DualPipe”項目尤為引人注目。這是一種創新的雙向流水線并行算法,最初在《深度搜索-V3 技術報告》中被提出。通過實現正向和反向計算-通信階段的完全重疊,并減少流水線氣泡,DualPipe極大地提升了訓練過程中的資源利用效率。

與此同時,DeepSeek還開源了名為“EPLB”的專家并行負載平衡器。在專家并行(EP)模式下,不同的專家模型被分配到不同的GPU上執行。然而,由于不同專家的負載可能因當前任務而異,保持GPU間的負載平衡成為了一個挑戰。為了解決這一問題,DeepSeek采用了冗余專家策略,并開發了一套啟發式方法,以確保復制的專家能夠合理地分配到各個GPU上,從而實現負載平衡。考慮到DeepSeek-V3中使用的分組受限的專家路由策略,EPLB還嘗試將同一組的專家放置在同一節點上,以減少跨節點的數據流量。

為了便于社區復現和部署這一算法,DeepSeek在eplb.py文件中公開了EP負載均衡算法的實現細節。該算法能夠根據估計的專家負載,計算出平衡的專家復制和放置計劃。當然,預測專家負載的具體方法并不在此次開源的范圍內,但通常可以使用歷史統計數據的移動平均值作為參考。

除了上述兩個核心項目外,DeepSeek還分享了來自其訓練和推理框架的分析數據。這些數據涵蓋了通信-計算重疊策略以及底層實現細節,旨在幫助社區更好地理解并優化深度學習訓練過程。

DeepSeek的這一系列開源舉措,不僅展示了其在深度學習并行策略優化方面的深厚積累,也為整個社區提供了寶貴的資源和啟示。隨著這些項目的逐步推廣和應用,我們有理由相信,深度學習訓練的效率將得到進一步的提升。