英特爾于近日在其開發(fā)人員專區(qū)宣布,OpenVINO 2025.0版本已正式面世,這一里程碑式的更新標(biāo)志著在性能提升、生成式AI模型支持以及對英特爾神經(jīng)處理單元(NPU)的優(yōu)化方面取得了顯著進(jìn)展。

據(jù)悉,OpenVINO 2025.0版本引入了對FLUX.1圖像生成模型(包括Dev與Schnell版本)的官方支持,這意味著開發(fā)者可以在英特爾的CPU和GPU上,通過GenAI流水線運行這些模型。通過Optimum-Intel工具,開發(fā)者能夠?qū)С鯢lux模型,并結(jié)合Text2ImagePipeline功能,實現(xiàn)圖像的生成。特別針對Flux模型對精度變化的高度敏感性,英特爾進(jìn)行了深度優(yōu)化,確保了圖像生成的高性能與準(zhǔn)確性。

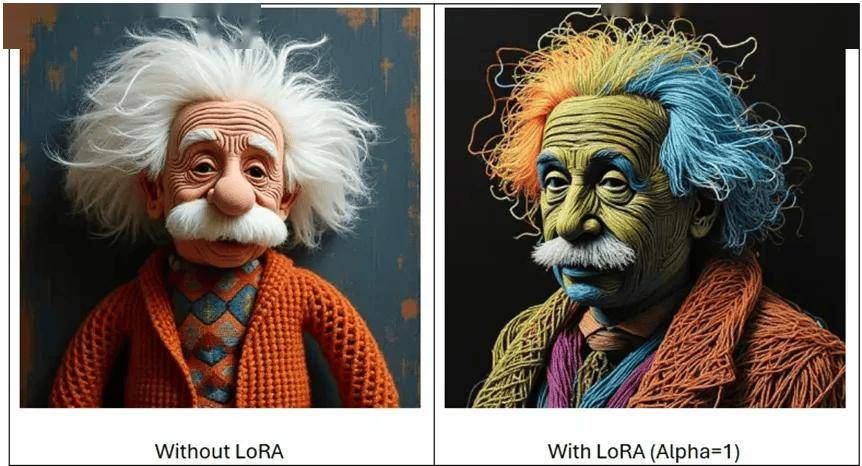

新版本還增添了Image2Image與Inpainting兩大功能。Image2Image允許用戶以圖像和文本為輸入,生成全新的、可控性更強的圖像;而Inpainting則能夠通過掩碼圖像,替換輸入圖像中的特定區(qū)域,實現(xiàn)局部內(nèi)容的再生。這兩種流水線均兼容LoRA適配器,為用戶的定制化需求提供了更多可能性。

在LLMPipeline API方面,OpenVINO 2025.0版本也帶來了創(chuàng)新。它引入了提示詞查找解碼的預(yù)覽支持,這是對推測解碼的一種簡化。通過直接查找機制取代傳統(tǒng)的草稿模型,這一功能在處理高相似性的請求時,能夠顯著減少生成延遲。例如,在問答場景中,答案將直接基于作為提示詞一部分的文檔生成,從而展現(xiàn)出明顯的性能優(yōu)勢。

英特爾還透露,他們正在積極支持和驗證最新的模型,包括Mistral-7B-Instruct-v0.2和Qwen2.5。同時,基于LLama和Qwen架構(gòu)的DeepSeek蒸餾模型也得到了支持。這些舉措無疑將進(jìn)一步拓寬OpenVINO的應(yīng)用領(lǐng)域和場景。

OpenVINO 2025.0版本首次實現(xiàn)了對NPU的加速支持。開發(fā)者現(xiàn)在可以通過PyTorch的torch.compile接口,輕松調(diào)用英特爾NPU的算力。此前,OpenVINO已在CPU和GPU上得到了廣泛支持,并且其性能已經(jīng)接近原生OpenVINO推理。這一新功能的啟用方式也極為簡便,為開發(fā)者提供了更多的選擇和靈活性。