AI芯片巨頭Cerebras近期遭遇了一場前所未有的挑戰,其CEO Andrew Feldman在一次訪談中透露,公司正被大量運行DeepSeek-R1大語言模型的訂單淹沒。

Cerebras,這家以推出高性能AI晶圓級芯片著稱的公司,其單塊芯片便能提供驚人的125 PFLOPS峰值算力,并搭配高達1.2PB的內存容量,一直以來都是AI領域的佼佼者。然而,這次DeepSeek-R1的火爆需求,顯然超出了他們的預期。

DeepSeek-R1,這款被視作AI領域分水嶺的模型,其預訓練成本僅為GPTo1等主流模型的十分之一,但效果卻與之相近甚至更佳。Feldman表示,DeepSeek不僅在當前展現出了巨大影響力,更將推動更大規模AI系統的誕生。隨著成本的降低,AI市場的潛力正在被不斷挖掘。

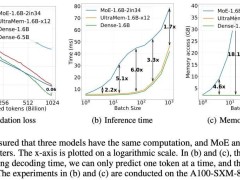

在Cerebras的官方展示中,其晶圓級AI芯片在部署DeepSeek-R1 70B時,性能達到了1508 tokens/s,遠超GPU。然而,這款模型在推理過程中,卻需要消耗大量算力。由于采用了Chain-of-thought(CoT)方法增強推理能力,模型需要將多步問題分解為中間步驟,并在需要時執行額外計算。這種逐字推理的方式,對于整段提示詞的推理需要多次進行,從而導致了算力的巨大需求。

面對這一痛點,Cerebras提出了利用蒸餾技術將大模型的“知識”轉移到小模型中的解決方案。大模型被稱為教師模型,而較小的模型則被稱為學生模型。通過這種方式,客戶可以在保持模型精度的同時,降低推理過程中的算力需求。

Cerebras在官網上表示,DeepSeek R1在蒸餾到Llama 70B后,精度幾乎沒有下降。為了改善用戶體驗,Cerebras為客戶提供了一種標準做法:利用開源在Hugging Face上的DeepSeek模型參數作為教師模型,蒸餾出一個較小的學生模型用于實際部署。

Feldman強調,DeepSeek作為首個頂級的開源推理模型,是開源AI的重大勝利。通過蒸餾技術,開源模型只需公開模型參數,研究人員無需訪問源碼便能復制新AI模型的進步。他認為,DeepSeek的經濟性不僅震撼了整個AI行業,更將吸引更多投資流向尖端AI芯片和網絡技術。

盡管有些人擔心計算成本的下降會導致市場萎縮,但Feldman指出,過去50年的歷史表明,降低成本反而能夠擴大市場容量。無論是電腦還是智能手機,價格的降低都推動了產品的普及。因此,他相信DeepSeek和Cerebras的推動將進一步加速AI市場的增長。

自去年8月開始提供公共推理服務以來,Cerebras自稱是“世界上最快的人工智能推理服務提供商”。然而,面對高昂的405B模型成本,該公司目前主要提供的是蒸餾后的70B模型。Feldman表示,雖然有一部分客戶愿意為更高的準確性支付更高的成本,但大多數客戶更傾向于選擇價格實惠的模型。