智元機器人在科技創新領域邁出了重要一步,正式揭曉了其首個通用具身基座大模型——智元啟元大模型(簡稱GO-1)。這一發布標志著具身智能技術取得了突破性進展。

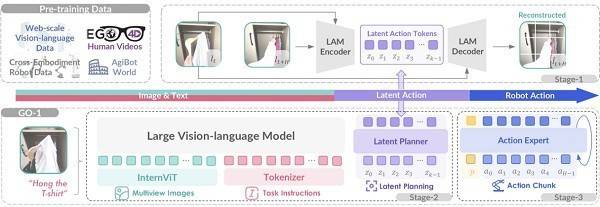

GO-1大模型的核心在于其創新的Vision-Language-Latent-Action(ViLLA)架構,該架構由多模態大模型(VLM)與混合專家模型(MoE)兩大組件構成。VLM通過海量互聯網圖文數據的訓練,獲得了卓越的場景感知和語言理解能力。而MoE則進一步細分為隱式規劃器(Latent Planner)和動作專家(Action Expert),前者通過大規模跨本體和人類操作數據,實現了對動作的深刻理解;后者則憑借百萬真機數據的訓練,具備了精細的動作執行能力。這三者之間的緊密協作,不僅使GO-1大模型能夠學習人類視頻,還實現了小樣本快速泛化,極大地降低了具身智能的應用門檻。

GO-1大模型的問世,意味著具身智能的全面革新。它能夠結合人類和多種機器人數據,使機器人具備革命性的學習能力,可廣泛應用于各類環境和物品中,迅速適應新任務,學習新技能。同時,GO-1大模型支持部署到不同形態的機器人本體,實現高效落地,并在實際應用中持續進化。

GO-1大模型的四大特點尤為突出:首先,它能夠結合互聯網視頻和真實人類示范進行學習,從而更好地理解人類行為,提升服務質量。其次,GO-1大模型具備強大的小樣本快速泛化能力,能夠在極少數據甚至零樣本的情況下,迅速適應新場景和新任務,顯著降低了使用門檻和后訓練成本。再者,GO-1大模型作為通用機器人策略模型,能夠在不同機器人形態之間遷移,實現快速適配和群體升智。最后,得益于智元的數據回流系統,GO-1大模型能夠在實際執行中遇到問題時持續學習進化,變得越來越智能。

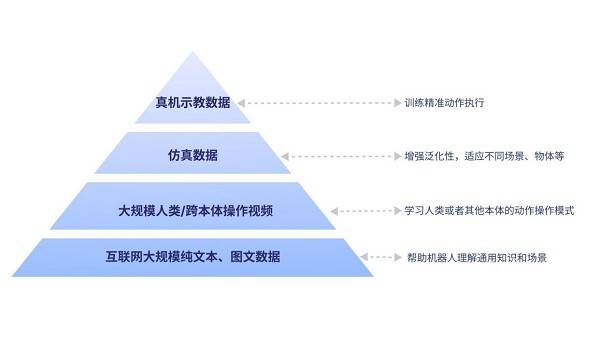

GO-1大模型的構建基于具身領域的數字金字塔模型,該模型吸納了人類世界多種維度和類型的數據。數字金字塔的底層是互聯網的大規模純文本與圖文數據,為機器人提供通用知識和場景理解的基礎。往上是大規模人類操作/跨本體視頻數據,幫助機器人學習動作操作模式。再往上則是用于增強泛化性的仿真數據,使機器人能夠適應不同場景和物體。而金字塔的頂層,則是高質量的真機示教數據,用于訓練精準動作執行。

相較于現有的Vision-Language-Action(VLA)架構,ViLLA架構通過預測隱式動作標記,有效彌合了圖像-文本輸入與機器人執行動作之間的鴻溝。它能夠充分利用高質量的AgiBot World數據集以及互聯網大規模異構視頻數據,顯著增強策略的泛化能力。基于ViLLA架構,GO-1大模型能夠接收多相機的視覺信號、力覺信號、語言指令等多模態信息,直接輸出機器人的動作執行序列。

GO-1大模型為機器人提供了全面的“基礎教育”和“職業教育”,使機器人天生就能適應新場景,輕松面對多樣化的環境和物體,快速學習新的操作。例如,當用戶給出“掛衣服”的指令時,GO-1大模型能夠根據看到的畫面理解任務要求,設想操作步驟,并最終執行完成整個任務。

在更深層次的技術層面,GO-1大模型在構建和訓練階段學習了互聯網的大規模純文本和圖文數據,使其能夠理解“掛衣服”在此情此景下的具體含義和要求。同時,通過學習人類操作視頻和其他機器人的操作視頻,GO-1大模型能夠知道掛衣服通常包括哪些環節。通過仿真不同衣服、衣柜和房間,以及模擬掛衣服的操作,GO-1大模型能夠理解環節中對應的物體和環境,并打通整個任務過程。最后,由于學習了真機的示教數據,機器人能夠精準完成整個任務的操作。

GO-1大模型的推出,標志著具身智能正朝著通用化、開放化、智能化的方向快速邁進。機器人將能夠在不同場景中執行多種任務,而無需針對每個新任務重新訓練。同時,機器人將不再局限于實驗室環境,而是能夠適應多變的真實世界。機器人將能夠理解自然語言指令,并根據語義進行組合推理,而不再局限于預設程序。