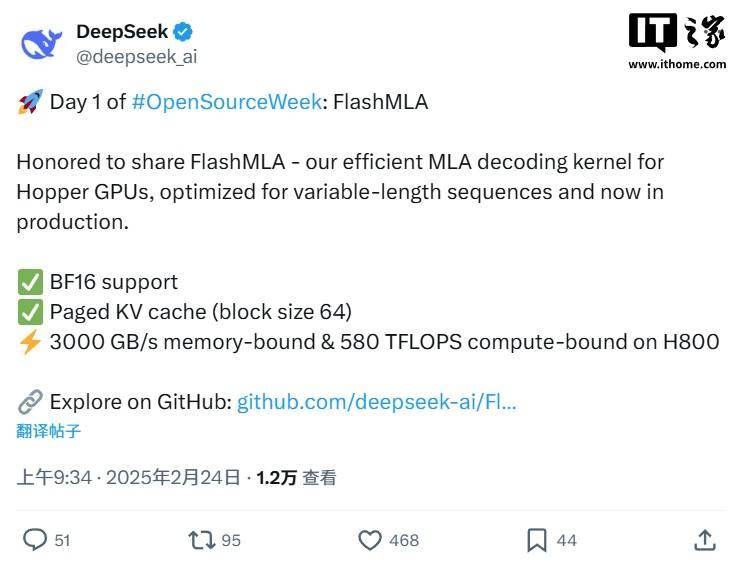

DeepSeek于近日宣布啟動了一項名為“開源周”的活動,旨在向公眾開放其技術資源。此次活動的首個開源項目名為FlashMLA,它是一個專為Hopper GPU優化的高效MLA解碼內核,特別適用于處理可變長度的序列數據。

FlashMLA的開源地址已經公布在GitHub上,供開發者們自由下載和使用。根據官方介紹,要使用FlashMLA,用戶需要滿足以下條件:具備Hopper GPU、CUDA 12.3或更高版本,以及PyTorch 2.0或更高版本。安裝過程也相對簡單,只需運行python setup.py install命令即可完成。

為了驗證FlashMLA的性能,DeepSeek提供了一系列的基準測試。在使用CUDA 12.6和H800 SXM5的條件下,FlashMLA在內存受限配置下可達到3000 GB/s的帶寬,而在計算受限配置下則能達到580 TFLOPS的算力。這些測試數據充分展示了FlashMLA在處理大規模數據時的出色性能。

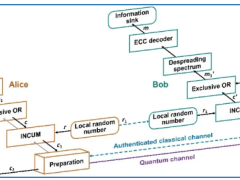

在使用方面,FlashMLA提供了簡潔明了的API接口。開發者可以通過from flash_mla import get_mla_metadata等語句輕松引入相關功能,并根據需求進行調用。例如,通過get_mla_metadata函數獲取MLA元數據,然后利用flash_mla_with_kvcache函數進行解碼操作。這些接口設計充分考慮了開發者的使用習慣和需求,使得FlashMLA更加易于上手和使用。

FlashMLA的開源無疑為深度學習領域注入了新的活力。它不僅提供了高效、可靠的解碼內核,還為開發者們提供了一個學習和交流的平臺。隨著越來越多的開發者加入到FlashMLA的使用和開發中來,相信它會不斷得到完善和優化,為深度學習領域的發展做出更大的貢獻。