近日,清華大學沈陽團隊的新作《DeepSeek攻略》再度引起廣泛關注,本次攻略深度探討了AI領域的一個獨特現象——AI幻覺。

許多用戶在體驗DeepSeek等大語言模型時,或許都曾遭遇過看似言之鑿鑿,實則與事實大相徑庭的回答。這些回答,正是AI幻覺的一種體現。

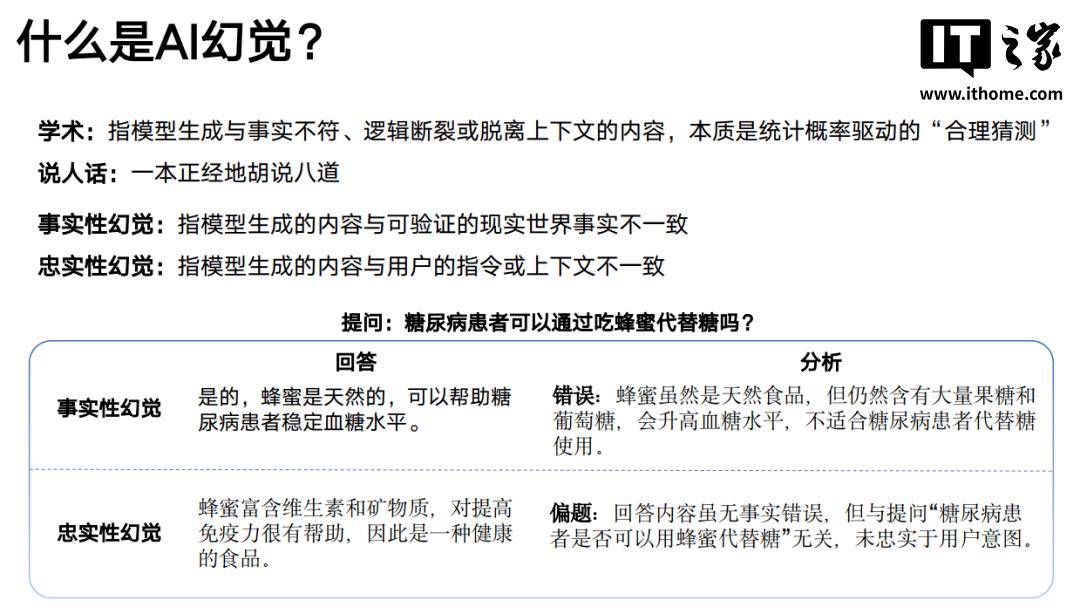

在《DeepSeek攻略》的第五部分中,詳細解析了AI幻覺這一概念。AI幻覺,簡而言之,即模型生成的內容與實際情況不符,邏輯斷裂或脫離上下文。這些“不合理”的輸出,其實是統計概率驅動下的“合理猜測”。

AI幻覺主要分為兩類:事實性幻覺與忠實性幻覺。前者指的是模型生成的內容與可驗證的現實世界事實不一致;后者則是模型生成的內容與用戶的指令或上下文存在偏差。

那么,為何會產生AI幻覺呢?原因主要有以下幾點:數據偏差導致模型放大了訓練數據中的錯誤或片面性;泛化困境使得模型難以處理訓練集外的復雜場景;知識固化讓模型過度依賴參數化記憶,缺乏動態更新能力;意圖誤解則在用戶提問模糊時,讓模型容易“自由發揮”。

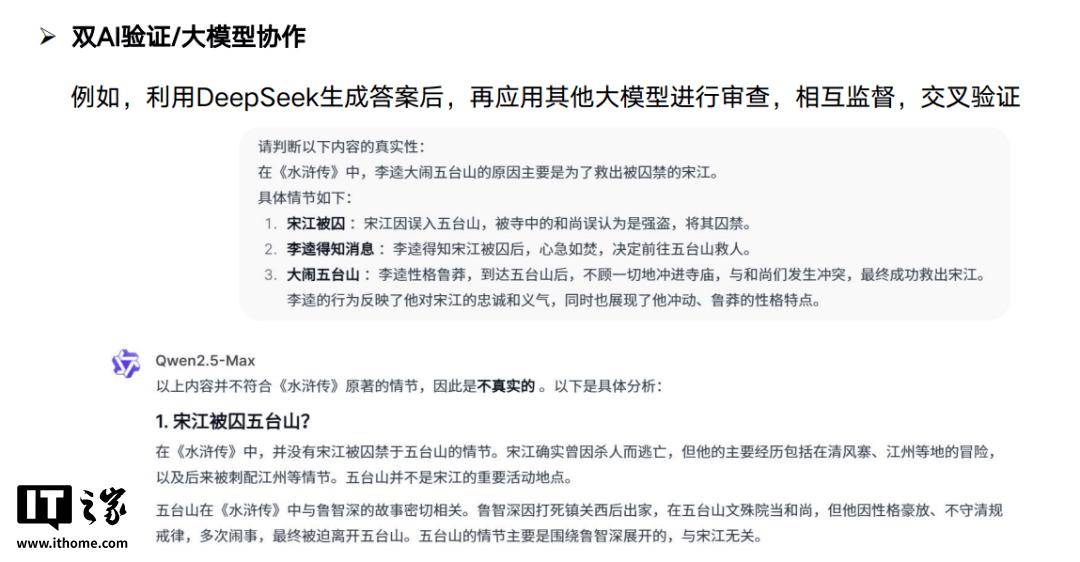

為了減緩AI幻覺的影響,作為普通用戶,我們可以采取一些措施。例如,開啟聯網搜索功能,讓AI對齊信息顆粒度,減少“胡說八道”的幾率。在編寫提示詞時,提前做好知識邊界的限定,降低模型虛構的可能性。使用多款AI模型進行交叉驗證,也是一個有效的方法。

盡管AI幻覺在現階段仍無法完全杜絕,但它在某些領域卻具有創造力價值。對于需要創新思維的領域,AI幻覺或許能激發新的靈感。當然,要讓AI幻覺的“想象力”為我們所用,還需要逐步建立方法論,并經過合理的驗證過程。

本次分享的《DeepSeek攻略》PDF版本為原汁原味的原版,避免了網上眾多被魔改、內置廣告的版本,為讀者提供了更加純凈的閱讀體驗。